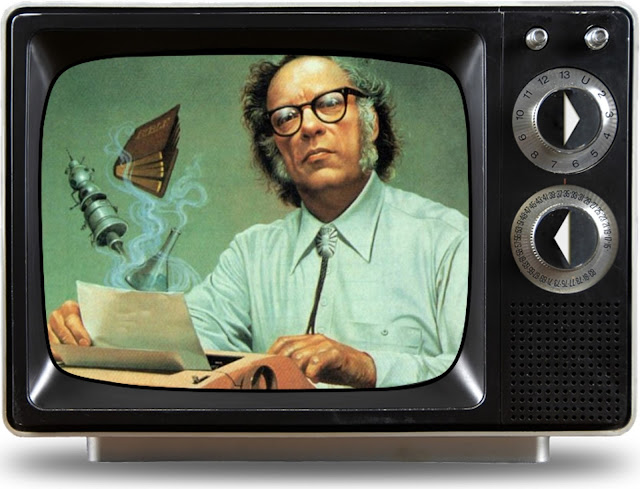

LAS LEYES DE LA ROBÓTICA NO SON UN SEGURO DE VIDA ⚠️

I. A robot may not injure a human being or, through inaction, allow a human being to come to harm.

II. A robot must obey the orders given it by human beings except where such orders would conflict with the First Law.

III. A robot must protect its own existence as long as such protection does not conflict with the First or Second Laws.

― Isaac Asimov, Three Laws of Robotics

Hay decisiones, que pueden tomarse de una manera fría, calculada y automática, sin la necesidad de ser un psicópata. Ni siquiera tienes que ser, por así decirlo, puede hacerlo un programa básico por ti. Cuanto más básico sea este programa, las decisiones serán más deterministas.

UN ROBOT NO PIENSA, EJECUTA ALGORITMOS

Si se trata de un algoritmo simple, las recompensas en el proceso de toma de decisiones están claras, y cada paso que das es simple, te parecerá que ni siquiera estás pensando. De hecho si esto lo hace un algoritmo sencillo, no está pensando, simplemente seguirá la flecha hasta que encuentre la recompensa, al final del proceso de toma de decisiones. Será sencillo, rápido y poco humano, de cara a los resultados. Sí, poco humano…

En cambio, si queremos darle un poco más de realismo a este proceso de toma de decisiones, de forma que simulemos una mente humana, el algoritmo tiene que ser forzosamente más complejo. Tendremos que ponderar las variables con probabilidades, introducir un coeficiente de eficiencia, ya que a cada paso habrá un desgaste, y además tendremos que introducir penalizaciones, que sumen de forma negativa... y no solo recompensas, ya que en la vida real, una mala decisión siempre acarrea consecuencias. Este algoritmo, ya sería algo más aproximado a la realidad, pero aún así… no dejaría de ser una función o una ecuación.

El caso sencillo sería un proceso determinista con caminos simples y unidireccionales. El algoritmo complejo, se correspondería con un proceso estocástico, en el que los caminos no serán únicos y probablemente el proceso de toma de decisiones, fuese algo más largo.

Aunque visto desde fuera y si no sabemos que hay una máquina detrás, si vemos solamente el resultado, aunque en ambos casos sea una máquina, el segundo modelo será más aproximado al comportamiento humano, por ser más errático. ¿Te das cuenta como una inteligencia artificial puede simular el comportamiento humano, sin necesidad ni siquiera de emular emociones?

LA INTELIGENCIA ARTIFICIAL NO ENTIENDE DE CONSECUENCIAS

Tomar decisiones nos hace libres, pero la vez nos responsabiliza las consecuencias estas decisiones en nosotros mismos y en el medio. Los algoritmos como tales no se equivocan, no asume consecuencias, ni generan karma cuando calculan y ejecutan, porque simplemente siguen un programa.

Por todo lo anterior, el ser humano ha empezado a delegar ya los procesos de toma de decisiones, en algoritmos que le quiten de cometer errores, que le quiten de ser responsables de sus decisiones, y por tanto, que también le libere de asumir las consecuencias, o el karma de las mismas.

En principal problema, es que si optamos por no ser nosotros los que toman las decisiones, delegando este proceso en un algoritmo impersonal, entonces la pregunta es ¿dónde quedamos nosotros? ¿dónde queda nuestra libertad? En el momento en el que hemos renunciado a ser nosotros quienes tomen las decisiones, hemos renunciado a la responsabilidad, y por tanto hemos renunciado a la soberanía sobre nosotros mismos.

Resulta una verdadera tentación, querer separarse por unos instantes de la realidad. Entiendo perfectamente y no juzgo, a todos aquellos que durante esta época, optan por evadirse. Quizás en otro momento de mi vida, les hubiera juzgado. Hoy no. Si esto fuese solamente cambiar de canal, poner otro que nos guste más y quedarnos ahí. Al final del día, decir que todo ha sido un mal sueño ¿te imaginas?

¿CONFIARÍAS TU VIDA A LAS LEYES DE LA ROBÓTICA?

Pero desde el momento en que cedemos voluntariamente la soberanía sobre nosotros mismos, para no cargar con la responsabilidad, el error, las consecuencias o el karma, pueden hacer lo que quiera con nosotros, ya que hemos dejado de ser soberanos ¿No lo habías pensado? ¿Por qué si no, la primera ley de la robótica pretende ser un seguro de vida para el ser humano? Un robot no hará daño a un ser humano o, por inacción, permitirá que un ser humano sufra daño.

Damos por hecho que estos algoritmos que forman parte del comportamiento de este agente, que es como lo llamaríamos en el contexto de la inteligencia artificial, o robot funciona y calcula, en base a un programa desarrollado por un ser humano ¿verdad? Bueno pues imagínate que quien escribe ese programa, no siente la menor empatía por los seres humanos.

Puedes tomar la decisión de seguir siendo libre: de cambiar la evasión por aprovechar de la mejor manera posible el tiempo que tenemos. Si el entorno no nos ofrece una recompensa fácil, o no la vemos, o no la encontramos, vamos a tener que crearla nosotros mismos. No hay otro remedio ni más atajos. Porque si buscas el atajo de no ser tu, terminará siendo otro.

Buscar recursos o una recompensa fuera de nosotros mismos, en una época de abundancia, tarde o temprano termina por traer una mejor o peor recompensa. Pero cuando nos vemos solos, y es más, todos nos estamos protegiendo para no entrar en pérdidas, no queda otra alternativa que sacar de dentro de nosotros mismos y ser fuertes.

LA DESCONFIANZA EN LO HUMANO HACE QUE BUSQUEMOS SEGURIDAD EN LA IA

Tampoco puedes pretender ganar, obtener recursos o una recompensa, un premio... si no estás dispuesto a dar algo. Y cuando me refiero a dar algo no me refiero a comprar o una garantía. Básicamente porque no hay garantías: la seguridad es una ilusión, a la que nos gusta aferrarnos con demasiada frecuencia. Se nos olvida que el mundo gira, y que de un día para otro, puede dar la vuelta. No pensamos en ello, hasta que no nos toca enfrentarnos a esa realidad cara a cara.

Y ahora mismo la realidad con la que nos enfrentamos, nos dice que se están tomando decisiones que nos afectan, sin tener en cuenta un lado humano de las mismas, sino solamente un cálculo numérico.. Tan frío como puede sonar, quién toma las decisiones o es un ente no humano, o es un algoritmo. A los psicópatas por cierto, les considero como no humanos. Por lo que a mí respecta, están al mismo nivel que los aliens o los robots biológicos. No sé de quién me fiaría menos, si de un alien con un psicópata.

La única manera de convivir con un psicópata, es que este elija racionalmente cómo actuar, o se autoprograme. con un código similar a las leyes de la robótica, para poder vivir en sociedad. Con lo que estaría al mismo nivel, qué un robot. Yo no sé tú pero yo no me quedo tranquilo sabiendo algoritmo más o menos complejo está decidiendo por mí.

Una persona puede ser buena o mala, se puede discutir con ella, se puede pelear con ella, según su juego se la puede convencer o no, pero cuando hablamos de inteligencia artificial estamos hablando del vacío absoluto. No hay nada a lo que enfrentarse, ese es el problema. No hay alguien detrás que responda, solo es un algoritmo que calcula, ejecuta y no responde ante nadie.

No debemos confiar nuestro destino al vacío.

Somos antihéroes en un mundo que ha dejado de creer en los hombres buenos.

Comentarios

Publicar un comentario

El mundo no va a cambiar por lo que vayas a decir ahora, créeme... pero si crees que merece la pena y debes decirlo ¡adelante! Es tu decisión.