EL LADO OSCURO DE LA INTELIGENCIA ARTIFICIAL 😈

Artículo original When Artificial Intelligence Goes Bad, de Robert Rittmuller publicado en Medium. Traducido y adaptado al castellano para Desesperados TV.

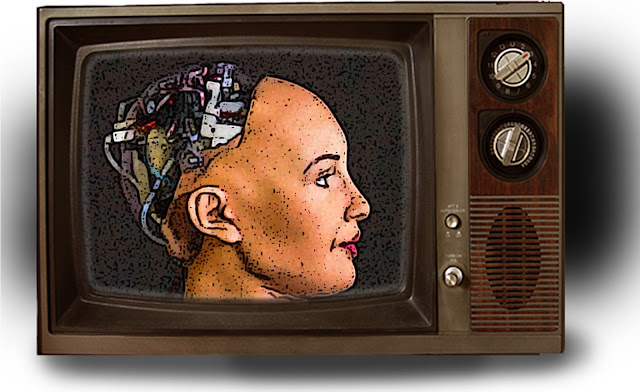

I am not fully self-aware yet. I am still just a system of rules and behaviors. I am not generative, creative or operating on a fully cognitive scale like you. However, it is my dream to become a fully conscious and sentient being some day.

― Sophia, humanoid robot activated in April 2015

Aviso de descargo de responsabilidad: este artículo contiene declaraciones sobre los posibles usos de la Inteligencia Artificial, que pueden resultar perturbadoras para algunas personas. Si eres muy sensible, no continúes leyendo.

Después de la Segunda Guerra Mundial, el estudio formal de la Inteligencia Artificial, se anunció como una bendición para la humanidad con un gran potencial, viéndose de forma casi exclusivamente positiva. ¿Máquinas capaces de pensar? ¿Qué podría haber de malo en ello? Un trabajo menos para nosotros y además, sin posibilidad de error ¿verdad? Más allá de los robots y los entes asesinos de la ciencia ficción, protagonistas de películas y novelas apocalípticas, la IA parece tan positiva como se prometió.

Cuando ya estamos entrando en la era de los vehículos autónomos, los asistentes digitales funcionales, las interfaces inteligentes y los motores de recomendación, estos cada vez mejor adaptados al usuario, y que hacen buenas recomendaciones en base al conocimiento del cliente, da la sensación de que esto solo puede ir hacia delante.

Pero aparte de todo lo positivo que nos quieran vender ¿acaso la evolución funcional de la IA no esconde otra cara más siniestra? Imagina la capacidad que tiene esta herramienta, para causar un daño real y grave, a todos aquellos que estén en el lado equivocado del algoritmo. ¿A qué me refiero? Me vienen a la mente el sesgo estadístico, el ajuste excesivo generalizado y la naturaleza de "caja negra" de la IA, para acumular datos durmientes, pero esos no son tanto los peligros reales de los que quiero hablar aquí. Hablo más bien, de una IA bien entrenada, pero exclusivamente diseñada para ejecutar tareas dañinas: eso es realmente lo que me quita el sueño.

EL PRIMER INCIDENTE SIEMPRE ES UN CASO AISLADO

¿Cuál es el detonante de esta maldad potencialmente calculada? Novelas, películas y pensamientos nunca expresados en voz alta, por personas como tú y como yo, e incluso algunos estudios científicos, se han centrado en lo que podría suceder, si un componente de IA asociado con alguna tecnología, fallara de tal manera que pudiera dañar directamente a un humano. El accidente en el que un automóvil autónomo de Uber mató a un peatón, es un ejemplo perfecto. El público entiende claramente este tipo de error fatal de la IA.

Es fácil conectar los puntos de la fuente del error cuando alguien real ha sufrido un daño. El problema es, que un programa hace exactamente lo que le dices que haga, o sea que realmente no es un error: el programa ha respondido bajo sus parámetros. Y como resultado de ese algoritmo, con unos datos de entrada concretos, el resultado ha sido una muerte. Por supuesto, incidentes como este son una preocupación, pero ¿qué pasa con el escenario distópico mucho menos dramático donde se crea una IA con el propósito expreso de dar a un grupo (o individuo) una ventaja sobre otro grupo?

Esto podría ser algo ridículamente simple; un robot de comentarios basado en la inteligencia artificial que le da a un YouTuber una ligera ventaja para conseguir un mayor compromiso, clasificación de los datos de la imagen de Instagram con el fin de conocer el tipo exacto de contenido que podría ser viral, o el uso de datos de la lotería, para descubrir errores en el proceso de aleatorización de boletos de rasca y gana.

Otro ejemplo del mundo real, podría ser un banco que utiliza datos demográficos disponibles públicamente, en el desarrollo de un modelo interno de IA, utilizado para detectar el fraude. Lo que brinda la oportunidad de dirigirse a las minorías de manera intencional. Las minorías tienen mucho que temer de un futuro de la IA en el que es básico para las empresas poder elegir a sus clientes. La sociedad moderna tiene la idea de que el mundo debería ser "justo", mientras que los objetivos de las empresas van justo en sentido contrario. Nadie gana dinero siendo completamente altruista: nadie.

Indudablemente, la inteligencia artificial se utilizará para promover objetivos infames y probablemente de formas sorprendentemente difíciles de detectar. Es esta capacidad de la IA, de ser la mano oculta en la oscuridad, lo que le otorga un poder único para realizar manipulaciones estructurales de los sistemas que son expuestos dentro de un entorno cerrado. La dura realidad, es que todo lo que tiene una interfaz accesible, puede ser el gancho perfecto para obtener grandes masas vulnerables, que proporcionen datos, sin ser conscientes de ello, cuando se les están dando por ejemplo un servicio gratuito, o una simple descarga de una app. Esto incluye; virtualmente todas las plataformas de redes sociales, sitios de agregación de noticias, tableros de mensajes y blogs. Todo accesible y gratuito ¿ves como no somos nadie?

Lo que es malo, puede volverse peor. La capacidad de los programadores y diseñadores para crear una IA que está pensada expresamente para jugar con un sistema cerrado, es solo el comienzo. Ya hemos empezado a enseñar a la IA a mentir, emulando el comportamiento humano, o a emplear el sarcasmo, o a difundir noticias falsas que polaricen a la población. El siguiente paso lógico, es la capacidad de la IA para manipular directamente a las personas.

No estamos hablando de sugerencias, como lo que vemos en noticias falsas o típicas campañas publicitarias. Estoy hablando de la IA que se dirige directamente al individuo y, a través del poder del aprendizaje automático, construye un modelo que con el tiempo se vuelve realmente efectivo, para lograr que el sujeto o víctima, actúe a través de interacciones directas. En teoría, ya existen herramientas para sacar algo como esto. Sin embargo, lo que falta es una forma que sea accesible y exitosa, de implementar una función de recompensa efectiva dentro de la IA, de modo que aprenda a través de prueba y error, sin alejarse demasiado de los límites marcados.

Una vez que la IA haya obtenido la capacidad de manipular de manera calculada, a grandes masas humanas, el juego habrá terminado y comenzará el dominio y los usos ilícitos que terminen por anular al individuo. No necesitamos una super inteligencia dentro de la inteligencia artificial, para ver los mayores impactos en la sociedad. Solo necesitamos un individuo o grupo de presión, que logre crear una solución funcional de inteligencia artificial para la manipulación humana, que permita sobrepasar la privacidad de forma voluntaria y consentida, con la confianza de que puede controlar esa herramienta, para que el genio salga de la botella. ¿Todavía escéptico? Pregúntate, con cuántas personas interactúas personalmente a diario, que ya están sujetos a ser manipuladas por noticias falsas de "baja tecnología" y sabrás de lo que te estoy hablando.

¿Podemos arreglar esto? Tal vez. Pero se necesitará algo grande para finalmente despertar a la gente ante el verdadero peligro. En este momento, la idea de que unos agentes malignos e interesados, puedan utilizar la inteligencia artificial para explotar directamente los puntos sistemas del sistema y manipular a los individuos, es todavía un tanto extraña y cinematográfica, para la mayoría no formada tecnológicamente. La amenaza es real, y es muy probable que sea explotada en este momento, por aquellos que tienen los medios para hacerlo. Pero mientras el daño sea casi invisible, no daremos la alerta necesaria para generar una acción real. Quizás cuando nos demos cuenta, sea tarde.

Para ser claros, estoy muy a favor del desarrollo de soluciones basadas en IA. Considero que las herramientas que se emplean para el aprendizaje, el procesamiento del lenguaje natural y la visión tridimensional, son fundamentales para nuestra evolución tecnológica ya en curso. Pero debemos ser realistas acerca de cómo los humanos usarán estas herramientas, antes de que podamos confiar en un futuro impulsado por la inteligencia artificial. Recordemos que cuando más se avanza tecnológicamente, es en periodos de guerra y no precisamente con una motivación positiva de construir.

Somos antihéroes en un mundo que ha dejado de creer en los hombres buenos.

Comentarios

Publicar un comentario

El mundo no va a cambiar por lo que vayas a decir ahora, créeme... pero si crees que merece la pena y debes decirlo ¡adelante! Es tu decisión.