LOS ALGORITMOS NOS DICEN CÓMO PENSAR Y ESTO NOS ESTÁ CAMBIANDO 🔌

Artículo original Algorithms Tell Us How to Think, and This is Changing Us de Orge Castellano publicada en Medium. Traducido al castellano para Desesperados TV.

Back, you know, a few generations ago, people didn't have a way to share information and express their opinions efficiently to a lot of people. But now they do. Right now, with social networks and other tools on the Internet, all of these 500 million people have a way to say what they're thinking and have their voice be heard.

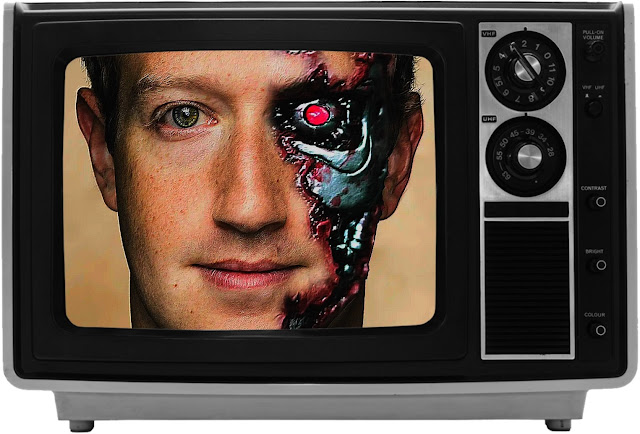

― Mark Zuckerberg, Facebook founder and CEO

A medida que los ordenadores aprenden a imitarnos ¿estamos empezando a ser más como ellos? Desde Silicon Valley predicen cada vez con más acierto, cómo vamos a responder a un correo electrónico, al reaccionar ante una imagen de Instagram de alguien, a determinar para qué servicios del gobierno somos aptos, y muy pronto un asistente de Google, podrá llamar por nosotros en tiempo real para pedir hora en la peluquería.

Hemos dejado entrar a los algoritmos prácticamente en todas partes, desde hospitales y escuelas, hasta los tribunales. Estamos rodeados de automatización con autonomía. Las líneas de código pueden decirnos qué ver, a quién ver, en qué fecha, e incluso a quién debe enviar el sistema judicial a la cárcel. ¿Estamos cometiendo un error al entregar tanta autoridad y control de toma de decisiones a las líneas de código?

Sin ser conscientes de ello, estamos obsesionados con los procedimientos matemáticos porque nos dan respuestas rápidas y precisas, a una variedad de problemas complejos. Los sistemas de aprendizaje automático se han implementado en casi todos los ámbitos de nuestra sociedad moderna.

Sin embargo, lo que deberíamos preguntarnos es: ¿estamos cometiendo un error al entregar tanta autoridad y control a la hora de tomar decisiones a las líneas de código? ¿Cómo los algoritmos afectan nuestras vidas? En un mundo en constante cambio, las máquinas están haciendo un gran trabajo al aprender a un ritmo acelerado, cómo se comportan los humanos: qué nos gusta, qué es lo que odiamos, y qué es lo mejor para nosotros. Actualmente estamos viviendo bajo la mirada y control de la tecnología predictiva ¡oye, autocompleta! Estamos dentro.

Los algoritmos han transformado drásticamente nuestras vidas al clasificar los datos de la masa social, introducidos por nosotros mismos y darnos resultados relevantes e instantáneos. Al recopilar grandes cantidades de datos, a lo largo de los años, hemos otorgado a las empresas el poder de decidir qué es lo mejor para nosotros.

Compañías como Alphabet o Amazon, han estado alimentando sus respectivos algoritmos con los datos captados y están instruyendo a su Inteligencia Artificial, para que use la información recopilada para adaptarse a nuestras necesidades, y ser más como nosotros. Sin embargo, a medida que nos acostumbramos a estas utilidades, acaso ¿No estamos ya hablando y comportándonos más como un ordenador? ¿No estamos acomodando nuestra percepción a la hora de elegir, como si estuviéramos en un menú de opciones en la barra lateral de una interfaz?

"Los algoritmos no son inherentemente justos, porque la persona que construye el modelo define el éxito". - Cathy O’Neil, científica de datos

A este ritmo tecnológico, es imposible no imaginar un futuro cercano, donde nuestro comportamiento esté guiado o dictado por algoritmos. De hecho, ya está sucediendo. Un algoritmo, diseñado para ayudarnos a escribir mensajes o respuestas rápidas. Google lanzó su última función en Gmail llamada Respuestas inteligentes en octubre pasado. Desde entonces, muchas personas han criticado al asistente, diciendo que sus sugerencias personalizadas son invasivas, hacen que los humanos se vean como máquinas, y algunos incluso argumentan que sus respuestas podrían influir en la forma en que nos comunicamos, o posiblemente cambiamos la etiqueta del correo electrónico.

El principal problema con los algoritmos es cuando se vuelven tan grandes y complejos, que comienzan a afectar negativamente a nuestra sociedad actual, poniendo en peligro la democracia. ¡Hola, Mark Zuckerberg!. Cuando un programa o servicio gratuito, adquiere un comportamiento similar al de un programa de vigilancia distópica. A medida que los sistemas de aprendizaje predictivo son cada vez más generalizados en muchas áreas de la sociedad ¿irán los algoritmos por el mundo, dominando nuestros pensamientos?

Ahora, vamos a tomar el enfoque de Facebook. En 2015, lanzaron su nueva versión de News Feed, que fue diseñada como una forma ingeniosa de recopilar y aumentar la participación de los usuarios, en una home de noticias personalizada, que les permite ver en primeras posiciones, el contenido que les ha gustado, que han compartido y comentado anteriormente.

El problema con los algoritmos "personalizados" es que pueden colocar a los usuarios en filtros burbuja o cámaras de eco. En la vida real, es mucho menos probable que la mayoría de las personas se involucren con puntos de vista que les parezcan confusos, molestos, incorrectos o aborrecibles. En el caso de los algoritmos de Facebook, les dan a los usuarios lo que quieren, y como resultado, cada feed de noticias personalizado, se convierte en un mundo único. Una realidad distintiva por sí misma, porque solo estamos viendo, lo que queremos ver, o lo que previamente hemos elegido ver.

Los filtros burbuja, hacen que sea cada vez más difícil tener un argumento público porque, desde la perspectiva del sistema, la información y la desinformación se ven exactamente iguales. Como Roger McNamee escribió recientemente en la revista Time: “En Facebook, los hechos no son un absoluto; son una opción que se deja inicialmente a los usuarios y a sus amigos, pero luego se amplían mediante algoritmos para promover el compromiso con la diversidad".

Los filtros burbuja crean una ilusión de que todos creemos lo mismo, y que hacemos o tenemos los mismos hábitos. Como ya sabemos, los algoritmos en Facebook agravaron el problema al aumentar la polarización y, en última instancia, dañar la democracia. La evidencia de que los algoritmos pueden haber influido en un referéndum británico o en las elecciones de 2016 en los EE. UU., ya ha quedado demostrada.

"Los algoritmos de Facebook hacen que prevalezcan en la visual de nuestra home de noticias, mensajes de contenido extremo, sobre mensajes neutrales, y esto puede darle más relevancia a la desinformación sobre la información, o las teorías de conspiración sobre los hechos". - Roger McNamee, inversionista de Silicon Valley

En el mundo actual, en el que grandes masas de información compiten por verse en las primeras posiciones, filtrar la calidad del contenido plantea un gran desafío para algunas personas. La inteligencia artificial (utilizada sabiamente) podría potencialmente mejorar la experiencia online o ayudar a abordar de manera rápida, las crecientes cargas de contenido. Sin embargo, para funcionar correctamente, los algoritmos requieren datos precisos sobre lo que está sucediendo en el mundo real, y así tener una referencia de veracidad para evaluar.

Las empresas y los gobiernos deben asegurarse de que los datos de los algoritmos no estén sesgados o sean inexactos. Como en la naturaleza, nada es perfecto, se espera que los datos sesgados de forma natural estén ya dentro de muchos algoritmos, y eso pone en peligro no solo nuestro mundo online, sino también el físico, el real. Los canales pueden tener un funcionamiento perfecto, pero el error y el sesgo, están implícitos en el combustible, en quien bajo su perspectiva subjetiva, ha introducido los datos.

Es imperativo abogar por la implementación de marcos regulatorios más sólidos, para que no terminemos en un Salvaje Oeste tecnológico. Deberíamos ser extremadamente cautelosos sobre el poder que le damos a los algoritmos. El riesgo aumenta, cuando hablamos de transparencia, y las implicaciones éticas detrás de las decisiones y los procesos que toman, con las consecuencias sociales que afectan a las personas.

Por ejemplo, la inteligencia artificial utilizada en los tribunales puede mejorar el sesgo, pero también discriminar a las minorías teniendo en cuenta los factores de "riesgo", como sus vecindarios y los vínculos o parentescos de personas inocentes con criminales. Estos algoritmos podrían cometer sistemáticamente errores basándose en el lugar de residencia o parentescos familiares y enviar a humanos inocentes y reales a la cárcel, por el simple hecho de “estar allí”.

¿Estamos en peligro de perder nuestra humanidad? Como experto en seguridad, Bruce Schneier escribió en su libro Click Here to Kill Everybody, "si dejamos que los ordenadores piensen por nosotros y que los datos de entrada subyacentes estén dañados, pensarán mal y es posible que nunca lo sepamos".

Hannah Fry, matemática del University College London, nos lleva a un mundo en el que los ordenadores funcionan libremente. En su reciente libro Hello World: Being Human in the Age of Algorithms, argumenta que como ciudadanos, deberíamos prestar más atención a las personas que están detrás del teclado, las que programan los algoritmos.

"No tenemos que crear un mundo en el que las máquinas nos digan qué hacer o cómo pensar, aunque es muy posible que terminemos en un mundo así", dice. A lo largo del libro, ella se pregunta con frecuencia: "¿Estamos en peligro de perder nuestra humanidad?"

Por el momento, todavía no estamos en la etapa donde los humanos, no salgan en la foto. Nuestro papel en este mundo no se ha dejado de lado, y parece que seguirá siendo así por algún tiempo. Los seres humanos y las máquinas pueden trabajar juntos con sus fortalezas y debilidades. Las máquinas tienen fallos y cometen errores como nosotros. Deberíamos tener cuidado con la cantidad de información y poder al que renunciamos, ya que los algoritmos son ahora una parte intrínseca de la humanidad y una vez creados, ya no van a desaparecer.

Somos antihéroes en un mundo que ha dejado de creer en los hombres buenos.

Comentarios

Publicar un comentario

El mundo no va a cambiar por lo que vayas a decir ahora, créeme... pero si crees que merece la pena y debes decirlo ¡adelante! Es tu decisión.